Community & iZombie

Monday, 30. August 2021

Kurz zu zwei Serien, die ich im Covid-Alltag gut fand.

Community

Community beginnt als eher gewöhnliche Seifenoper mit ungewöhnlichen Charakteren, ein bisschen Friends in einem anderen Setting.

Community-Colleges sind wohl ein in der USA tatsächlich schief angesehener alternativer Ausbildungsweg. Viel Material für eine seichte Komödie über schräge Typen. Aber schon über den Verlauf der ersten Staffel kippt das, und plötzlich wird die Serie komplett absurd. Aber auf eine gute Art. Mit lustigeren Stories, aufwändigeren Folgen (Paintball!), den Zuschauer einbeziehenden Witzen. Das neue Konzept trägt dann problemlos durch die Folgestaffeln. Ich kenne keine bessere Komödienserie, und dabei habe ich The IT Crowd gesehen – was zwar witzigere Sketche hatte, aber nicht so gut als Serie funktionierte.

iZombie

iZombie ist ein bisschen morbide Komödie, ein bisschen Krimi-Drama. Olivia wird zum Zombie und findet eine Nische als Gerichtsmedizinerin, die Gehirne von Mordopfern isst, dadurch ihre Erinnerungen erhält und so mit einem Polizeipartner die Täter stellen kann.

Das hat zwar auf der einen Seite viel von einer simplen Jugendserie, man muss sich nur angucken was der Hauptdarstellerin alles passiert und wozu sie schon in der ersten Folge befähigt wird. Was nicht unbedingt für die Serie spricht. Aber andererseits fand ich die Balance zwischen interessanten Episodengeschichten und übergreifender Serienstory sehr gut gelungen. Auch, wie die anderen Charaktere aus ihrem Umfeld weiter benutzt werden hat was. Dabei trifft der Humor, iZombie ist durchgehend immer wieder ziemlich witzig. Am Ende ist es dann einfach eine gute Mischung.

Linksammlung 34/2021

Friday, 27. August 2021

Vier neue Links diese Woche:

Edward Snowden erklärt in The All-Seeing "i": Apple Just Declared War on Your Privacy nochmal, warum Apples Ausspionieren der eigenen Nutzer so schlimm ist.

Dubai Is A Parody Of The 21st Century ist ein Video des Channels Adam Something, der neben dieser überzeugenden Einordnung sonst die Projekte von Elon Musk zerlegt.

Zu OnlyFans Drops Planned Porn Ban, Will Continue to Allow Sexually Explicit Content fällt mir ein, wie einer meiner Ethik-Professoren sagte: Wir brauchen als Gesellschaft nicht mehr Normen und Werte, sondern weniger.

Bei Ein bisschen Frieden geht es um Lafontaine, Wagenknecht und die Linkspartei. Man muss dazu wohl diesen Facebook-Post von Lafontaine und diesen Talkshow-Auftritt von Wagenknecht sehen um einzuschätzen, dass die beiden bei Covid ziemlich abgedreht sind.

Der große Unterschied zwischen Deus Ex 1 und Human Revolution/Mankind Divided

Monday, 23. August 2021

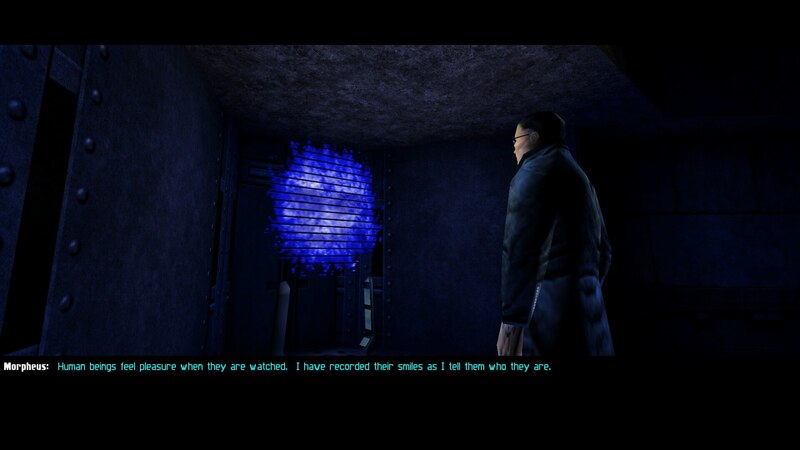

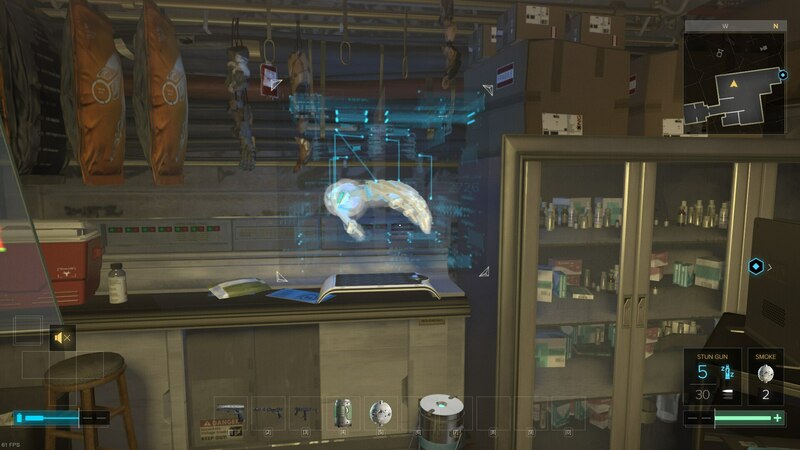

Der große Unterschied zwischen dem originalen Deus Ex und seinen Prequels ist nicht die Grafik, zumindest meine ich die hier nicht. Es sind auch nicht die modernisierten Spielmechaniken. Sondern es ist die Konsistenz der Story, welche Geschichte erzählt und wie sorgsam die Welt mit den Hintergrundinformationen aufgebaut wird.

Leichte Spoilerwarnung.

Die Story in DX1

Das erste Deus Ex ist eine Cyberpunk- und Verschwörungstheoriegeschichte. Auf der einen Seite ist da der Transhumanismusaspekt: JC Denton ist nicht einfach ein Agent, er ist ein Agent mit Nanoaugmentierungen. Noch dazu einer der ersten, genetisch dafür befähigt. Das wird im Spiel für viele Spielmechaniken genutzt, aber es ist auch ein Aspekt der Story.

Allerdings ist es der kleinere Aspekt der Story. Das übergeordnete Thema sind die Verschwörungstheorien der Neunziger. Das steht nicht im Gegensatz zu Cyberpunk, sondern ist ganz im Gegenteil elementarer Bestandteil des Genres. Die große technikgestützte Verschwörung findet sich zum Beispiel bei so prominenten Genrevertretern wie Neal Stephensons Snow Crash.

DX1 nimmt diese Verschwörungstheorien und lässt sie alle wahr werden. Viren aus dem Labor, die von den Illuminati zur Machtergreifung genutzt werden, gestützt von den Notstandsgesetzen der FEMA und absoluter Internetüberwachung – und das sind nur die Elemente aus dem Intro. Wie sich Menschen in einer solchen Welt verhalten würden, wie der Spieler sich verhalten muss, das wird dann zum Hauptthema des Spiels.

Die Story in HR/MD

Human Revolution und Mankind Divided wurden viele Jahre nach DX1 veröffentlicht, natürlich ist dann spielerisch vieles anders. Dass sie trotzdem das Gefühl vermitteln, Deus-Ex-Spiele zu sein, war ihre große Leistung. Aber die aufgebaute Welt und wie die Story funktioniert ist tatsächlich sehr anders.

Wieder ist es Cyberpunk mit Verschwörungstheorien als Träger der Handlung, aber der Fokus der Geschichte liegt da nicht. Sondern er liegt auf Rassismus. Augmentierung und der Rassismus gegen Cyborgs ist das einzige Thema, das neben den Spielereignissen in den Nachrichten vorkommt, es ist selbst worüber die Leute auf der Straße reden. Die (mechanisch) augmentierten werden diskriminiert und gefürchtet, was in HR sogar Motivation des Antagonisten ist sie zu vernichten. Während es bei DX1 bei der Verschwörung um die Gesellschaft und Politik ging, oder kurz um Macht, wird sie bei den Nachfolgern vermischt mit dieser Rassismus-Einordnung.

Das macht alles aber leider viel uninteressanter. Rassismus mag ein bestimmendes Thema in den USA sein, aber er hat keine verschiedenen validen Seiten. Es ist einfach ein zu lösendes Problem. Während man bei DX1 noch mit den verschiedenen Gesellschaftssystemen sympathisieren oder zumindest ihre Auswirkungen durchdenken konnte, geht es vor allem bei MD mehr darum eine Parabel zu erzählen. Die dann soweit geht, dass in Mankind Divided im wesentlichen ein Nazi-Konzentrationscamp besucht wird. Die Botschaft wird mit Holzhammer transportiert, was wenig ansprechend ist selbst wenn man ihren Inhalt wertschätzt.

Die gescheiterte Konsistenz

Drei statt zwei Hauptthemen in eine Geschichte zu packen macht die Sache nicht einfacher. Die beiden moderneren Spielen machen dabei viel sehr gut, vor allem füllen sie ihr Universum dicht mit Hintergrundinformationen. Das blendet, HR und MD wirken beide beim Spielen überzeugend. Doch bei all der Arbeit haben es die Entwickler übersehen, dass ihr Kernszenario blödsinnig ist. Und so unrealistisch DX1 mit seinen Nanoaugmentierungen und Roswell-Aliens auch gewesen sein mag: Es erzählte immer eine konsistente und folgerichtige Geschichte, wovon später keine Rede mehr sein kann.

In Deus Ex 1 sind Augmentierungen selten. Sie sind kaum ein Thema in den Gesprächen mit der Bevölkerung oder in den Nachrichten, da geht es stattdessen um den Virus und die politische Krise. Mechanische Augmentierungen (und die neue Nanotechnologie) ist dem Militär vorbehalten. Das passt: Niemand würde sich in echt die Beine abhacken, um sich danach mechanische einzusetzen. Oder Hände, die dann zwar schneller und stärker greifen, aber die nicht fühlen. Günther Hermann und Anna Navarre, die Kollegen-Cyborgs der Unatco, werden im Spiel explizit als außergewöhnliche Menschen präsentiert, die große Opfer gebracht haben.

Nicht so in HR/MD, obwohl beide Spiele weit vor DX1 und in einer sehr nahen Zukunft spielen. Hier sind Augmentierungen allgegenwärtig. Überall in der Spielwelt laufen Leute mit mechanischen Körperteilen herum. Es sei sogar ein Problem, wird erzählt, dass Nicht-Augmentierte keine Jobchancen mehr haben. Und man sieht Straßengangs, die sich mechanische Körperteile zusammenstehlen und einsetzen. Und all das, obwohl – und hier wird es komplett affig – mechanische Augmentierung in diesem Universum die regelmäßige Einnahme eines sehr teuren Medikaments brauchen, um nicht vom Körper abgestoßen zu werden.

Superteures Medikament als Abhängigkeit geht natürlich überhaupt nicht zusammen mit den Millionen von Cyborgs und der postulierten Zwang zur Mechanisierung der einfachen Arbeiterschaft. Stattdessen gibt es sogar Cyborg-Prostituierte als Storyelement! Denn die Spiele bemerken und adressieren dieses Problem nicht. In einer solchen Welt wären cybernetische Modifikationen außergewöhnlich selten: Das Militär würde sie Soldaten aufzwingen, die kapitalistische Elite könnte sich vielleicht bestimmte ihnen nützliche erlauben, und versehrte Menschen würden – wenn finanzierbar – Defekte beheben. Aber das wars, es wäre ein Nischenthema, nicht der allesbestimmende politische Diskurs der in den Spielen gezeigt wird. Aber HR/MD fehlt dafür die Selbstreflexion.

Und deswegen funktioniert die "Alle Verschwörungstheorien sind wahr"-Welt mit der ihr eigenen Konsistenz in DX1, während die "Jeder zweite hackt sich freiwillig Körperteile ab, macht sich von einer Droge abhängig und wird danach leider diskriminiert"-Geschichte in HR/MD nicht im Ansatz glaubwürdig ist.

Zusammenfassung

Ja, auch die Variante in HR/MD kann Cyberpunk sein, aber dieses Gore-Cyberpunk ist eine sehr andere Ausprägung des Genres. Ausgestaltet ist die Geschichte in den beiden neueren Spielen leider schwach, die Hintergrundgeschichte macht aufgrund der inneren Widersprüche überhaupt keinen Sinn. Das ist erstmal okay, weil man es beim Spielen nicht direkt merkt. Und vielleicht ist es auch okay, weil die Story keine intellektuelle Cyberpunk-Geschichte sein will, sondern eine überzeugende Anti-Rassismus-Parabel.

Den Spielen hätte es aber doch gutgetan, wenn die Nachfolger sich mehr an die Struktur des Vorgängers gehalten hätten. Die ist zwar auch unrealistisch, aber in sich konsistent und eine nur leicht verzerrte Zukunftsvision unserer Welt. Über und mit Verschwörungstheorien als Hauptfokus ließen sich noch viele weitere gute Geschichten erzählen, Politik und Macht wird als Thema auch nie langweilig werden. Stattdessen Rassismus zu thematisieren hat sicher seinen Platz, seinen Wert und seine Berechtigung, aber so wie es hier gemacht wurde übersetzt sich das nicht in eine überzeugende Geschichte. Und genau da liegt für mich der Unterschied zwischen Original und Prequels: Wie stimmig, überzeugend und konsistent das aufgebaute Universum ist.

Linksammlung 33/2021

Friday, 20. August 2021

Ein paar Links, die diese Woche mein Interesse geweckt haben:

Die neuen Bildformaten bei The past, present and future of image formats werde ich weiter beobachten. Bisher habe ich nur hier im Blog ab und an WebP eingesetzt, ansonsten ist es immer noch JPEG oder PNG. Wäre schön immer auf JPEG XL setzen zu können, dafür ist der Browsersupport aber noch nicht da.

Bei Apples CSAM Scan – Der unverzeihliche Sündenfall kann ich Gerrit nur zustimmen.

Der Monatsbericht von Pine ist diesmal riesig: Introducing the PineNote stellt nicht nur mit dem PineNote ein E-Ink-Tablet vor (in Richtung reMarkable und Onyx Boox Max), sondern auch beim Telefon, Laptop und der Smartwatch geht es weiter.

8 product lessons we can learn from Google+ verpasst in meinen Augen die wichtigste: Mit der Realnamenspolitik von Google+ und verstärkt durch die vorhergehende Reader-Abschaltung hatte es sich Google mit seinen Kernnutzern verscherzt, aber ohne überzeugte Fans hatte gerade ein Facebook-Klon keine Chance. Daran scheitern seitdem reihenweise Google-Produkte. Allerdings ist die Perspektive des Artikels von 2014, vielleicht zu nah dran.

How the Pandemic Now Ends ist die große Frage. Die Einschätzung im Artikel ist sehr US-lastig, aber der Virus ist hierzulande ja nicht anders, da lässt sich einiges übertragen.

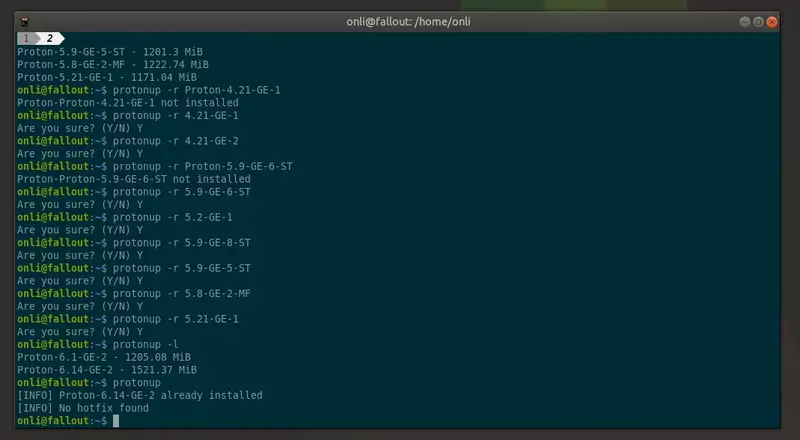

Mit protonup leichter das neueste Proton-GE installieren

Wednesday, 18. August 2021

Der kleine Helfer protonup installiert auf dem System komfortabel die neueste Version von Proton-GE (GloriousEggroll). Das ist eine alternative, schneller mit Updates versorgte Variante von Proton, die von einem Redhat-Entwickler gepflegt wird. Der Vorteil: Damit laufen schlicht mehr Spiele besser. Und die Installation ist mit protonup jetzt noch einfacher (via).

Falls pip3 nicht installiert ist erst das, danach damit protonup installieren:

pip3 install protonup-ng

Update 01.05.2022: protonup kommt bisher mit dem neuen Releasenamen von Proton-GE nicht zurecht. Stattdessen kann man protonup-ng benutzen. Ich habe deswegen die Installationsanleitung oben umgestellt. Die Benutzung unten bleibt gleich.

Kurz einrichten:

protonup -d "~/.steam/root/compatibilitytools.d/"

Und schon kann die neueste Version installiert werden:

onli@fallout:~$ protonup Ready to download Proton-6.14-GE-2 Size : 412.57 MiB Published : 2021-08-02 Continue? (Y/N): Y Downloaded 100.0% - 412.62 MiB/412.57 MiB [INFO] Installed in: .steam/root/compatibilitytools.d/Proton-6.14-GE-2

Außerdem lassen sich alte Proton-GE-Installationen auflisten und entfernen:

onli@fallout:~$ protonup -l Proton-6.1-GE-2 - 1205.08 MiB Proton-4.21-GE-1 - 962.43 MiB Proton-4.21-GE-2 - 962.5 MiB Proton-6.14-GE-2 - 1521.37 MiB Proton-5.9-GE-6-ST - 1202.5 MiB Proton-5.2-GE-1 - 1597.76 MiB Proton-5.9-GE-8-ST - 1212.55 MiB Proton-5.9-GE-5-ST - 1201.3 MiB Proton-5.8-GE-2-MF - 1222.74 MiB Proton-5.21-GE-1 - 1171.04 MiB onli@fallout:~$ protonup -r Proton-4.21-GE-1 Proton-Proton-4.21-GE-1 not installed onli@fallout:~$ protonup -r 4.21-GE-1 Are you sure? (Y/N) Y

Das ist netter als ich glaubte, denn ich hatte keine Ahnung, dass die Installationen so verdammt groß sind.

Nach einem Steam-Neustart kann dann wie gehabt in den Einstellungen generell die neue Protonversion als Standard gesetzt oder sie nur für bestimmte Spiele aktiviert werden.

Nette kleine Erleichterung, fand ich.

Acht Tipps für Blogger

Monday, 16. August 2021

Dieser Blog lebt seit 2008. Wie populär Blogs sind, ein bisschen sogar was ein Blog ist, hat sich im Laufe der Zeit gewandelt. Bei mir haben sich dabei ein paar Hinweise für Blogbetreiber angesammelt.

Klar: Nur weil jemand lange etwas macht, muss er nicht gut darin sein. Aber "so ist es gut" trifft glaube ich bei keinem der folgenden Tipps so wirklich den Charakter. Wenn doch, werde ich es zumindest begründen und man darf die Berechtigung selbst beurteilen.

1. Überlege: Warum bloggst du?

Es gibt viele Gründe ins Internet zu schreiben. Unbedingtes Mitteilungsbedürfnis. Ein überall zugängliches Nachschlagewerk mit Ergänzungen anderer zu haben. Berühmt zu werden. Geld zu verdienen. Die eigene Expertise zu vertiefen und zu präsentieren, was dann sogar zu einem besseren Job führen könnte. Manchen ist der Blog tatsächlich mehr ein voyeuristisches Tagebuch. Und es gibt sicher noch mehr.

Bei mir beispielsweise war es ungefähr so: Damals waren Blogs ziemlich populär und ich fand sie faszinierend. Ich las generell viel, mir gefiel das Schreiben und auch gerade die weichen Schulfächer. Aber dann entschied ich mich für den Anfangspunkt einer technischen Karriere. Etwas später einen eigenen Blog aufzusetzen war dann vor allem ein Mittel, um sich ein bisschen das Schreiben zu bewahren. Und ich dachte, ich könnte neben Linuxwissen viel vom Studium dokumentieren (dazu kam es kaum).

Was am Ende der Daseinszweck des Blogs ist kann eine Mischung der obigen Gründe, kann ein einziger sein. Aber es schadet nicht, ihn bewusst im Kopf zu haben. Wahrscheinlich ist die Motivation am Anfang sowieso sehr präsent, aber die Ausprägung könnte unklar sein. Wenn das aber entschieden ist, sind ein paar Folgeentscheidungen einfacher. Beispiel: Gemischtwarenladen oder Themenblog? Braucht es ein Newsletterpopup? Analytics? Ist Werbung zu schalten zieldienlich? Wieviel Aufwand sollte in Artikel fließen, wie oft etwas veröffentlicht werden?

2. Suche dir ein (und nur ein?) Thema

Jeder Blog braucht ein Thema. Wie stark man sich dann daran hält hängt vom Blogziel ab.

Will ich mit dem Blog mich vor allem professionell in einem Bereich darstellen, dann sollte der Blog auch wirklich fast ausschließlich über dieses Thema reden. Der alte Blog von Isotopp wäre ein Beispiel dafür, ohne dass ich wirklich seine private Motivation kennen würde. Ist der Blog zum Geldverdienen da, schadet ein festes Thema auch nicht – ob es jetzt extrem wie beim Supermarktblog oder etwas aufgelöst bei Caschys erweiterten Techniknews ist.

Ein Blog kann auch ein Gemischtwarenladen sein und über mehrere Themen reden – so wie hier. Das macht es dann aber mehr zu einem privaten Blog. Ich wusste zum Beispiel bei der letzten Bewerbungsrunde nichtmal, ob ich diese Seite im CV verlinken soll, weil die letzten Artikel Kommentare zu Spielen und Filmen waren. Und bei jedem Leser besteht die Gefahr, dass er sich nur für einen kleinen Teil der Themen interessiert und den Rest als abschreckend empfindet. Aber es hat den Riesenvorteil, dass der Themenbereich das volle eigene Interesse ist, das Schreiben selbst wird einfacher.

Aber praktisch immer, wenn die Ziele sehr konkret sind, ist die Beschränkung auf ein einziges Thema wahrscheinlich die bessere Wahl.

3. Sei nett und interagiere mit Kommentatoren

Vor vielen Jahren bin ich jemandem auf einer Konferenz begegnet. Super sympathisch, wir redeten viel über alles mögliche. Nach der Konferenz landete der zugehörige Blog in meinem Feedreader. Da erschienen nur sporadisch Artikel, aber ich freute mich über die gelegentlichen Lebenszeichen und natürlich waren die meisten Artikel auch ansprechender, weil ich die Stimme dahinter hören könnte. Kürzlich war ein Artikel über ein Thema dabei, das ich interessant finde, ich hinterließ einen Kommentar. Und nun ja: Statt des Tonfalls von damals waren die Antworten Entgegnung, ein unheimlich schnell ins aggressive abgleitende und ellenlanges Dagegenreden, ohne es je durch eine freundliche Bemerkung zu entschärfen.

Leute, wenn ich bei jemanden hier in den Kommentaren mal so angekommen bin, schreibt mir eine Mail und weist mich darauf hin!

Denn in den Kommentaren Leser zu vergraulen, genau das soll ja nicht passieren. Kommentare zu erhalten ist toll, sie zeigen mir als Autor, dass ein Artikel gelesen wurde und genug Interesse für sogar einen Kommentar hervorrief. Deswegen verdient fast jeder Kommentar eine vernünftige Antwort. Vielleicht außer, unter dem Artikel hat sich eine wirkliche Diskussion entwickelt – die würde sonst erstickt. Denn egal welches Ziel der Blog hat: Eine Leserschaft zu haben fördert jedes davon und Kommentatoren sind der sichtbare Kern der Leserschaft. Warum sollte man sich selbst torpedieren und dann mit ihnen unfair umgehen?

Der Blog meiner Konferenzbegegnung ist nicht mehr in meinem Feedreader.

4. Kritisch ist gut, feindlich schadet

Ähnlich wie bei den Kommentaren, gilt diese Warnung vor der Selbstsabotage durch Feindseligkeit auch für Artikel selbst.

Wer heutzutage noch einen Blog führt ist wahrscheinlich etwas konträr zum Mainstream. Und es gibt gerade in Deutschland erfolgreiche Blogger, die einen sehr kritischen Tonfall pflegen. Ein Beispiel dafür wäre fefe. Was liegt da näher als die kritische Haltung zu betonen, dem eigenen Blog so etwas Charakter zu geben?

Die Gefahr ist, dass es ein schmaler Grat ist. Klar: Lese ich einen Artikel über irgendein Thema möchte ich die ehrliche Meinung und Gedanken des Autors, mehr noch bei einem Blogger als bei einem glattgebügelten Massenmedium. Aber wenn der Autor scheinbar in einer übertrieben rebellischen Haltung eines aufsässigen Jugendlichen stehengeblieben ist, wenn in jedem Artikel erstmal eine Prise Hass oder Verachtung ignoriert werden muss, dann wirkt das für Leser abschreckend.

Die Überbetonung der kritischen Haltung erzeugt aber Kontroverse und damit Interaktion. Halbwegs gut geführt motiviert das dann sogar, der Blog wirkt lebendig. Doch das täuscht, denn die Haltung gleitet unweigerlich ins trollige, was dann die Leserschaft massiv beschränkt.

Manchmal – wer sich hier angesprochen fühlt, möge mir bitte verzeihen – geht die Verachtung gegen den Hauptteil der eigenen Minderheitengruppe. Da wird dann zwanghaft signalisiert, wieviel noch besser man doch sei als alle anderen, die sich schon überdurchschnittlich mit einem Thema beschäftigen. Klingt so: Ja, ihr macht eure eigene Kleidung, aber ihr seid so blöd es mit einer elektrischen Nähmaschine zu machen, dabei sind die ohne Strom doch so viel verlässlicher! Und dann wird konstant gegen elektrische Nähmaschinen geschossen. Und auch in jedem angelehnten Thema wird die Abgrenzung zu anderen betont. Gruppendynamisch das Bilden von Out-Gruppen in der Out-Gruppe. Sowas verstehe ich nicht. Jedem möglichen Ziel des Blogs kann das nur schaden, selbst und gerade, wenn die Leidenschaft für stromlose Nähmaschinen beworben werden soll.

5. Verlinke den RSS-Feed

Ein RSS-Feed ist eine einfache XML-Datei, die jedes mal aktualisiert wird wenn im Blog ein neuer Artikel veröffentlich wurde. Feedreader prüfen diese Datei regelmäßig, hat sie sich verändert, können sie die Abonnenten des Feeds auf die neue Artikel hinweisen. Geht es nicht darum Leser auf Werbung zu schieben kann dann sogar im Feed der komplette Artikeltext enthalten sein.

Das ermöglicht es Lesern, Blogartikel in ihrem bevorzugtem Layout zu lesen. Und sie können so über einen langen Zeitraum vielen Seiten folgen. Selbst wenn ein Blog nur zweimal im Jahr einen Artikel veröffentlicht, ist er im Feedreader bekomme ich das mit. Dem Blog bietet das die Möglichkeit einer Stammleserschaft, ohne die durch tägliche neue Artikel aufrechterhalten zu müssen.

Jede Blogengine erstellt diese RSS-Datei automatisch. Fehlt sie, ist es keine Blogsoftware, sondern amateurhaftes Gestümper (siehe oben: kritische Haltung. Zu heftig?).

Feedreader sind oft zumindest teilweise kostenlos, z.B. Feedly, sehr günstig wie bazqux, oder frei und kostenlos auf dem eigenen Server wie das von mir genutzte FreshRSS.

6. Investiere minimal in die Technik

Viele Blogger sind mehr als Autoren, sondern beschäftigen sich auch mit der Webtechnologie dahinter. Man kann da viel machen und viele Blogger schreiben auch darüber. Da muss man nur aufpassen, dass nicht ungewollt plötzlich die Technik hinter dem Blog zum Thema wird. Denn das spricht im Zweifel nur wenige Leute an. Daher ist der erste Abschnitt hier: Nicht zu viel machen, vor allem nicht statt zu schreiben.

Aber ein paar Grundlagen sollten stimmen, weil es jedem hilft: Die Software zumindest so gut sein, dass man Artikel so schreiben kann wie es einem gefällt – egal, ob das jetzt der Marktführer Wordpress oder die auf Blogs fokussierte Nischensoftware Serendipity ist. Die Performance sollte stimmen, wenn die Seite 30 Sekunden zum Laden braucht schadet es wieder den eigenen Zielen.

Eine eigene Domain zu besitzen hilft, will man den Blog später mal umziehen. Domains sind meist auch nicht teuer, .de liegt etwa bei ~10€ im Jahr. Professioneller sieht es auch aus und die Namenssuche kann Spaß machen.

Man kann den Blog selbst hosten. Bei uberspace beispielsweise geht das technisch gut, relativ einfach und ist es nicht übermäßig teuer. Man kann alternativ auch einen guten Fremddienst wie Wordpress.com benutzen.

Aufpassen muss man nur bei Modediensten wie Medium oder Substack (daher kein Link). Solche gehosteten Dienste kommen alle paar Jahre und sind anfangs meist wirklich ein gutes Angebot. Gute Interfaces, einfacher als viele Alternativen, oft bringen sie dem Blogger auch direkt etwas Aufmerksamkeit durch eingebaute Communityfunktionen. Nach ein paar Jahren rennt der Idealismus und der Geldbeutel aus und es folgt – wie inzwischen bei Medium – die Paywall oder eingebaute Werbung.

Das ist dann schade um die reingesteckte Arbeit. Wenn eine eigene Domain setzbar ist kann man aber versuchen, den gerade hippen Dienste als simplen Startpunkt zu nutzen.

7. Zu Schreiben bringt einen Anspruch ans Schreiben

Okay, hier wird es ein bisschen sehr subjektiv. Aber es ist doch so: Wer bloggt, schreibt. Ob es jetzt mehr Beruf oder Hobby ist, primär werden Texte produziert. Wenn es aber nicht gerade ein Literaturblog ist, ist das nur Mittel zum Zweck. Sprache ist meist nicht der Fokus des Autors.

Dass man etwas darauf achtet was man da produziert ist wohl ziemlich selbstverständlich. Wieder egal dem Ziel, ist die Sprache komplett abschreckend – z.B. bei Unmengen an Grammatik- und Rechtschreibfehlern – schadet es.

Aber ich würde etwas weiter gehen: Hab ein bisschen Anspruch an deine Schreibe. Nicht, um möglichst intellektuell daherzusülzen, sondern um mit etwas Stilsicherheit saubere Texte zu produzieren. Vielleicht, weil es Achtung verschafft, aber im Zweifel, weil es der Selbstachtung hilft.

Weil es eine große Seite ist erlaube ich mir ein Negativbeispiel: Computerbase. Ich mag deren Reviews auf einer technischen Ebene. Aber man merkt sowas von, dass die Autoren zuerst Techniker und nur notgedrungen Schreiber sind. Wenn ich noch einmal lese, dass "unbeseeltes Objekt X zu gefallen weiß"! Bzw war es eben schon einmal zuviel, seitdem lese ich Reviews dort nur noch wenn mich das Thema absolut interessiert. Denn die Texte dort sind voll von diesem und ähnlichen Sprachbildern. Schief und überbenutzt ist da eine besonders miese Kombination.

Gerade schiefe Bilder ist etwas, was Journalisten schon in Schülerpraktiken rausgeprügelt kriegen. Ein technisches Objekt kann nichts wissen, es sei denn es ist ein Nachschlagewerk, aber auch dann kann es nichts wollen. Beides steckt in dieser Sprachhülse aber drin. Deswegen passt es nur in ganz anderen Situationen, aber auch dann wäre es ein ganz seltsamer Stil. Trotzdem benutzten sie das in jedem zweiten Review. Wenn man da auch nur minimal einen Blick für hat werden solche Texte unerträglich.

Ich zumindest würde mich als Autor solcher Texte schämen. Was manchmal auch passiert – denn wer regelmäßig schreibt und liest greift automatisch Trends auf, die manchmal im Nachhinein superpeinlich sind. Derzeit hat außerhalb der erzkonservativen Blase die halbe Journaille vergessen, dass die -en-Endung eine Gleichzeitigkeit ausdrückt – "nach dem Feueralarm sitzen die Studierenden auf der Wiese" sagt etwas anderes, als der Autor sagen wollte, nämlich dass die da sitzen und studieren statt dass dort die Studenten eben hingeflüchtet sind. Manchmal rutscht auch mir sowas durch, eine Weile stand bei mir vor jedem "und" plötzlich ein Komma. Aber ich bemühe mich. Anspruch eben. Manchmal funktionierts sogar.

Dann noch ein paar passende Fotos in den Artikel setzen (okay, wieder ein Thema für sich) und schon ist der Blog ein Stückchen über dem Durchschnittsniveau.

8. Das wichtigste: Wirklich bloggen

Keiner der oberen Punkte bringt etwas, wenn am Ende keine Artikel im Blogs landen. Daher im Zweifel einfach mal schreiben. Es braucht sowieso etwas Übung, damit das Schreiben zum Alltag wird, sodass irgendwann der Blog nahezu automatisch befüllt wird. Regelmäßigkeit hilft da.

Regelmäßig und oft genug Artikel zu veröffentlichen hilft auch, die Leser interessiert zu halten, die nicht per Feedreader oder Newsletter den Blog abonniert haben.

Wie seht ihr das? Ich weiß, dass hier ein paar Blogger mitlesen, geht ihr mit den Tipps konform? Solche Fragen an den Ende des Artikels zu stellen ist übrigens auch Handwerkszeug von Internetautoren geworden und wirkt daher mittlerweile auf mich oft unehrlich, weiß ich beim Blogger nicht von seinem ehrlichen Interesse. Von dem kann ich bei mir versichern, aber wer mich nicht kennt weiß natürlich nicht ob er mir glauben darf.

In die Richtung gäbe es also noch mehr Themen. Aber übers Bloggen bzw Schreiben zu schreiben ist auch eine Falle, außerhalb von Journalistenblogs gewinnt man damit nicht viel, oder? Mache ich ganz bewusst nur selten, aber gerade die Tipps zur Feindseligkeit und zur Sprache wollte ich hier mal irgendwo unterbringen.

Linksammlung 32/2021

Friday, 13. August 2021

Auf Wunsch und unterstützt mit einem Wallabag-Account wird die Linksammlung versuchsweise tatsächlich zu einem regelmäßigen Ding. Gedanken zu den verlinkten Artikeln sowie dem Format dieser Serie sind gern gesehen.

Diese Woche kann ich empfehlen:One Bad Apple ist eine technisch und juristisch fundiert erscheinende Kritik Apples Ankündigung, Bilder von Apple-Nutzern zu scannen und bei Fund vermeintlich illegaler Bilder nach Sichtung derselben(!) die Strafverfolgungsbehörden einzuschalten. Das beste was ich zu dem Thema gelesen habe, Apple kommt unheimlich schlecht weg. Nebenbei: Das ist ein Serendipity-Blog.

Die Perspektive bei Plesk vs. ISPConfig oder warum ein Open Source Web-Hosting Panel völlig ausreicht ist interessant für mich, weil mir diese grafischen Serverwaltungssysteme immer sehr kompliziert erschienen. Wenn man für Serververwaltung die Kommandozeile gewöhnt ist sind die eine ganz andere Welt.

Patrick Breyer listet bei Nachrichten- und Chatkontrolle die Lage der EU-Bemühungen, durch Anordnungen Verschlüsselung von Chatsoftware zu brechen. Wie auch bei der Apple-Backdoor geht das zusammen mit meinem letzten Artikel zu den negativen Folgen solchen Staatsgewaltmissbrauchs bzw solcher Grundrechtsverletzungen.

Uber scheint das Geld und die Möglichkeiten auszugehen, sagt End of the line for Uber. Dass eine Firma so groß werden kann ohne je Profit zu machen ist aber auch eigentlich unvorstellbar.

Wieder Linus von LTT, in I tried Steam Deck early and it's awesome zeigt er zwei Dinge: 1. Macht der Youtuber da in der Kürze der Zeit eine unheimlich gute Arbeit und prüft überraschend viele Aspekte der Hard- und Software, 2. scheint das Steam Deck wirklich eine große Sache zu werden und damit Linux eine noch bessere Spieleplattform.

Warum bei Anonymität, Privatsphäre und Sicherheit im Netz keine Kompromisse möglich sind

Wednesday, 11. August 2021

Es ist nicht überzogen zu sagen: Die gesellschaftliche Auseinandersetzung um Anonymität, Privatsphäre und IT-Sicherheit entzündet sich gerade zu einen echten Kampf. FOSS-Software spielt in diesem eine Sonderrolle, weil sie unheimlich schwer zu regulieren ist und so Fakten schafft. Dagegen und gegen Anonymität versprechende Firmen gehen Staaten und bestimmte andere Firmen aber verstärkt vor.

Doch kann es hier nicht einfach einen Kompromiss geben? Gibt es sinnvolle Regelungen, die nur da partiell Anonymität entfernen und in die Privatsphäre hineingreifen wo es wirklich sinnvoll ist? Nein, das ist völlig unmöglich und wäre bei umfassender Anwendung das endgültige Ende von Anonymität im Internet, eine nie dagewesene Reduzierung der Privatsphäre und eine gesamtgesellschaftliche Schwächung der IT-Sicherheit.

Zum Kontext: Dies ist eine Entgegnung auf einen Kommentar von Gerrit bei curius.de, der wiederum war wohl eine Reaktion auf meinen Kommentar zu seinem Blogartikel über die Datenweitergabe von ProtonMail an US-Behörden. Ich ziehe mir meine Position nicht völlig in der Kürze der Zeit aus dem Allerwertesten; Anonymität – wenn auch nicht in diesem Kontext – war Thema meiner Doktorarbeit. Außerdem arbeite ich momentan im Randbereich privatsphärenwahrender Kommunikation.

Die derzeitige gesellschaftliche und technologische Ausnahmesituation

Machen wir uns erst einmal kurz klar wo wir stehen: Am wahrscheinlichen Endpunkt einer historisch einmaligen Ausnahmesituation. Dem Staat gegenüber anonyme Kommunikationsmittel hat es praktisch nie gegeben. Wo kommuniziert wird, wird potentiell mitgehört und kontrolliert – das haben sich Staaten immer herausgenommen. Und doch haben wir sie derzeit.

Gerade der deutsche Zensor war eine historische Konstante, der nicht nur prüfte was die Bevölkerung untereinander sich schrieb und sagte, sondern auch was veröffentlicht werden durfte. Bekanntes Beispiel ist der Einfluss des Zensors auf die deutschen Aufklärer im 18. Jahrhundert. Geistig verwandte Fortführung davon ist die Zensur von Videospielen via einem Index, nichts anderes als einer Zensurliste ungewollter Kunst, oder die Impressumspflicht, die der Minimierung anonymer Publikationen dient. Gerade Deutschland hat also eine tradierte und aktive Zensur- und Kontrollpraxis. Das Land ist aber beim Zugriffnehmen auf Kommunikationsmedien nicht einmalig.

In Telekommunikationsinfrastruktur muss der Staat mithören dürfen, sagt dieser. Telefonleitungen beispielsweise wurden einfach angezapft. Bei Internettechnologie wurden solche Vorschriften früh übernommen. So gibt es verpflichtend Abhörschnittstellen bei jedem Email-Provider ab einer gewissen Kundenanzahl, mit denen dann das gesamte Emailpostfach heimlich mitgelesen werden kann. Auch andere Staaten sind da extrem, die USA beispielsweise verbot kurzerhand den Export von brauchbarer Verschlüsselung und versucht immer wieder, die Anwendung ganz zu verbieten.

Dieser absolute Überwachungsanspruch zusammengenommen mit den technischen Gegenmaßnahmen und Überwachungsmöglichkeiten schafft eine interessante Situation, die sowohl in die Richtung von unerreichten Freiheitsrechten als auch unbekannt totaler Überwachung ausschlagen kann:

- Unsere Kommunikation und unsere Alltagstätigkeit erfolgt mehr als jemals auf potentiell komplett abhörbaren Netzwerktechnologien.

- Gleichzeitig haben wir aber Verschlüsselungsmethoden gefunden, die den Nutzern dieser Dienste vollständige Schutz vor dem Mitlesen ihrer Kommunikationsinhalte gewähren könnten.

- Allerdings hat der Staat jetzt erstmals die Möglichkeit, unverschlüsselte oder Kommunikation mit geknackter Verschlüsselung vollständig aufzuzeichnen und auszuwerten.

Man kennt vielleicht dieses Bild der sich wiederholenden Geschichte. Und die Entgegnung, dass sich nichts wiederholt, es reime sich nur. Das passiert hier: Im Grunde laufen die gleichen Entwicklungen wie bei jedem Kommunikationsmedium – anfängliche Anonymität und Datensicherheit durch Ignoranz, dann bekommt der Staat Angst um seine Macht, dann wird mitgelesen. Hier aber ist die Dimension neu, mit der zum einen dagegen vorgegangen werden kann und wie vollständig zum anderen das Abhören durchgeführt würde. Und außerdem ist enorm anders, wie weit in den privatesten Lebensbereich die Technologienutzung und damit das Abhören hineinreicht. Es ist eine Weiterentwicklung der damaligen Situationen.

Sicherheit geht nicht stückchenweise

In dieser historisch einmaligen Situation rennen wir also in die Frage: Wieviel Anonymität und Privatsphäre wollen wir zulassen? Und damit in zwei Probleme: Der alte Kompromiss der staatlichen Legitimierung des Eingriffs war niemals gut und ist es heute noch weniger, zweitens ist die technische Konsequenz dieser Eingriffsermöglichung enorm.

Nehmen wir einen Chatanbieter, der bis jetzt vollständig anonymisierte und Ende-zu-Ende-verschlüsselte Kommunikation ermöglicht hat. Logdateien gibt es nicht. Die Entschlüsselung bräuchte für jede einzelne Nachricht jeweils das jahrelange Arbeiten von Supercomputern. Selbst Metadaten darüber wer wem schreibt wird mittels Datendurchmischung unerhebbar gemacht. In Sachen Datenschutz und Anonymität die perfekte Lösung – und nah dem, was Dienste wie Signal heute tatsächlich anbieten.

Wenn wir dem Staat hier einen Eingriff auch nur auf Einzelne erlauben, wird die Anonymität und der Datenschutz aller reduziert. Denn der ginge jetzt hin und sagte: Logdateien müsst ihr führen. Ergo ist der Dienst nicht mehr anonym, ein entsprechend mächtiger Angreifer kann die IP-Daten zuordnen. Dann sagt er: Mitlesen will ich auch. Also ist die gesicherte Privatheit der Kommunikation weg, weil die Ende-zu-Ende-Verschlüsselung abgeschafft wird.

Das ist keine Theorie: Genau das ist bei der Kommunikationslösung für Rechtssachen(!) passiert, da weder das Anwaltspostfach noch De-Mail eine direkt aktive integrierte Ende-zu-Ende-Verschlüsselung haben. Wenn staatliche Lösungen das schon bei so absolut kritischen Daten machen, dann sieht man wo das Ziel liegt. Und tatsächlich fordert "der Staat" derzeit die Abschaffung von Ende-zu-Ende-Verschlüsselung bei Chatdiensten und will das per Gesetz durchdrücken.

Der Angreifer ist mächtiger als je zuvor

Schlimmer: Es ist nicht so, dass diese Daten dann nur per Richterentscheidung in kritischsten Situationen erhoben werden. Sondern da sie nun als gewollte Schwachstelle in die Kommunikationssysteme eingebaut sind, stehen sie auch anderen Angreifern zur Verfügung. Das kann die Hackerbande aus Nordkorea sein, die sich Zugriff auf die nun erhobenen Logdateien verschafft. Oder, garantiert ist der Zugriff der Geheimdienste.

Das ist keine Verschwörungstheorie. Oder anders: Es war mal eine, aber sie hat sich als wahr herausgestellt. Dass die Geheimdienste eine umfassende Datenabhöraktion am Laufen haben war der Kern der Enthüllungen von Snowden. Die NSA will den gesamten Internetverkehr durchleuchten und soweit möglich speichern. Geheimdienste wie der BND helfen dabei, indem sie den Internetverkehr auf den sie Zugriff haben an diesen fremden Geheimdienst weiterleiten. So umgehen sie, dass sie keine Dauerüberwachung der eigenen Bürger durchführen dürfen – machen sie auch nicht, sie leiten nur die Rohdaten weiter und bekommen im Gegenzug Auswertungsergebnisse.

Ich halte das für Landesverrat – obwohl das bekannte Ausmaß der BND-Involvierung vergleichsweise gering ist. Doch selbst wenn die Einschätzung stimmen würde, Konsequenzen gab es ja nichtmal als bekannt wurde, dass Merkels Telefon abgehört wird. Welchen staatlichen Schutz können sich normale Bürger da erhoffen?

Und nebenbei: Ja, das geheimdienstliche Datensammeln ist mehr als das Mitlesen von Texten. Es schließt den Zugriff auf Audio- und Videodaten ein, inklusive der Fähigkeit, heimlich Kameras von Laptops und Smartphones aktivieren zu können. Das mag in einem kleineren Maßstab passieren, ist aber grundsätzlich auch eine Fähigkeit, über die Geheimdienste wie Strafverfolgungsbehörden verfügen wollen.

Aber nochmal: Es geht nicht alleine um Geheimdienste. Wer das für Aluhutzeug hält kann sich dieses Argument wegdenken. Auch ohne sie ist das Wirken des Gesetzgebers und der normalen Behörden zerstörerisch für die digitale Privatsphäre. Das Vorschreiben von Überwachungsmöglichkeit bedingt Systeme, die überwachbar sind – so trivial kann man es sehen. Überwachbare Systeme aber sind angreifbar, nicht nur von dem, der die Überwachbarkeit in Auftrag gegeben hat. Außerdem ist es völlig berechtigt, auch bei den derzeit nach Überwachungsmöglichkeiten schreienden Staatsgewalten ein enorm hohes Missbrauchspotential zu sehen. Und sei es nur durch Missbrauch einzelner - man denke an die Adressen von Zielpersonen, die wohl über Polizeicomputer an Naziterroristen weitergegeben wurden.

Das ist die Welt, in dem wir uns bewegen. Und in dieser kann es nur absolute oder keine Softwaresicherheit geben. Das diktiert die Technik, aber es diktiert auch das Angreifermodell. Da der Angreifer staatliche Stellen sind und damit fast allmächtig, ist die einzige Chance auf anonyme und private Kommunikation in den globalen Kommunikationssystemen das Erstellen von Kommunikationswegen, die vollständig von jedwedem Fremdzugriff geschützt sind und bei denen keine verwertbaren Metadaten anfallen. Auf Endgeräten, die von Hardware- bis Softwareebene vollständig sicher sind, sonst werden die angegriffen.

Von diesem Idealzustand sind wir weit entfernt, gerade die Software und die Hardwareseite ist ein Thema für sich – Apple zeigte gerade wieder, dass proprietäre Systeme die eigenen Nutzer ausspionieren und an Strafverfolgungsbehörden verraten. Wir können aber hoffen, dass der Zugriff über diese Ebenen noch nicht vollständig ist.

Mit den Grenzen könnten wir leben

Kommen wir zum Begriff des rechtsfreien Raums. Der sei die Folge, wenn der Staat keine Vollkontrolle hat. Das stimmt nicht, denn es ist ein maßlos überzogenes Konzept und pure Propaganda von Verfechtern staatlicher Überwachung.

Es geht nicht um Rechtsfreiheit. Es geht um Grenzen der Rechtsdurchsetzung. Diese Grenzen gibt es auch heute schon außerhalb des Netzes und wir glauben trotzdem nicht, dass in Deutschland keine Rechte mehr gelten würden.

Was wir machen, ist abzuwägen: Es gibt Gesetze, die in einem gewissen Maße akzeptiert werden. Andere Regeln sind veraltet, offensichtlich Grundrechtswidrig und gehören abgeschafft, wie damals die erlaubte Vergewaltigung in der Ehe oder heute (natürlich weniger schlimm) das fundamentalchristliche Tanzverbot. Aber wir haben auch heute natürlich ernste Missstände, wie das Verbot der Aufklärung über Abtreibungen. Die Gesellschaft in einem diffusen Prozess entscheidet dann, welche Regeln wie hart durchgesetzt werden, welche außer Kraft fallen schon bevor sie offiziell abgeschafft werden. Und schaut dabei auf die Verhältnismäßigkeit: Der Staat wirft keine Bombe auf einen kompletten Frankfurter Stadtteil, wenn Karfreitag dort jemand Musik abspielt. Selbst wenn die Musik ansonsten nicht abschaltbar ist.

Den Komplettanspruch der vollständigen Regeldurchsetzung mit allen Mitteln gibt es, aber er ist hoch autoritär und keine Mehrheitsmeinung. Und führt nicht zu einen Staat, in dem Menschen freiwillig leben würden.

Genau diesen Abwägeprozess gilt es auch im vermeintlich rechtsfreien Raum des Internets zu durchlaufen. Nationale Gesetze mögen in Einzelfällen gelten, aber wie und wie weit sie durchgesetzt werden können hat Grenzen. Es kann nicht weltweit jedwede Anonymität abgeschafft werden, nur weil ein Mensch einmal einem anderen eine Morddrohung geschickt hat. Oder: Ja, wir könnten das tun, aber es wäre völlig unverhältnismäßig.

Doch es gibt keinen Mittelweg, keinen Kompromiss, der die Grundrechtsaufhebung nur temporär für einige wenige erlauben würde, denn der Mechanismus dafür ist angesichts der übermächtigen Angreifer und der notwendigen Schwächung der Grundsicherheit verbaut. Wir sehen das bei den alten Kommunikationsmedien wie dem Telefonnetz: Die Protokolle dahinter sind komplett unsicher. Das ist der Grund, warum SMS keine besonders sichere Wahl bei einer Zwei-Faktor-Authentifizerung ist. Aber die Unsicherheit der Netze wurde – so die These – bewusst in Kauf genommen um Abhörbarkeit herzustellen. Auf jeden Fall wurde sie Jahrzehntelang nicht problematisiert. Es ging ja auch meist um nationale Netze, mit wenigen ausländischen Angreifern.

Die aber gibt es im globalen Internet. Gleichzeitig kommen wir da zu dem Problem, dass ganz verschiedene Staaten Daten von Firmen anfordern. Der eine mag dem demokratischen Deutschland noch vertrauen. Der in den Faschismus rutschenden USA dann schon weniger. Und dem genoziden China schon gar nicht. Aber die alle fordern verfügbare Daten an, zunehmend selbst bisher nicht verfügbare.

Die durchaus vernünftige Alternative ist, eine begrenzt mögliche Rechtsdurchsetzungsfähigkeit einfach hinzunehmen. Ja, dann kann der Staat eben nicht die IP des Senders einer unschönen Nachricht herausfinden. Aber wenn der Empfänger die Nachricht zur Anzeige bringt kann die Strafverfolgsbehörde den Text analysieren und findet den Sender vielleicht so. Oder es gibt es einen Informant im Umfeld des Täters. Sogar bei Naziterroristen hätte das funktioniert, wenn da sorgfältig gearbeitet worden wäre. Nur weil das Extreminstrument der vollständigen Internetüberwachung nicht verfügbar ist heißt das ja nicht, dass es gar kein Instrument für Strafverfolgungsbehörden gäbe.

Deswegen kann es hier keinen Kompromiss geben. Erstens, weil dann Kommunikationsdienste generell nicht mehr anonym und privat wären (insofern sie das heute sind). Zweitens, weil wir über die Vertraulichkeitseigenschaften von technischen Systemen reden, die bedroht werden durch skrupellose Angreifer mit den Fähigkeiten von Staaten, mit technischen fähigen Auswertungssystemen. Gegen die ist ein partieller Schutz über Regularien im Sinne einer verstaubten Bonner Behördenstube nicht mehr möglich.

Kopfhörer #2: Der DT 770 PRO (vs dem ATH-M50x)

Monday, 9. August 2021

Der DT 770 PRO wird von beyerdynamic als professioneller Kopfhörer vermarktet. Mit einer geschlossene Bauform hat er etwas passive Isolierung, ist "Made in Germany" und für die Reparierbarkeit gibt es im scheinbaren Kontrast zum fest angebrachten Kabel viele verfügbare Ersatzteile, was gut zu seiner extrem stabil wirkenden Konstruktion passt. Im Vergleich mit dem ATH-M50x kommt er gut weg.

Ich hatte mich schon auf den M50x eingeschossen und dann später bemerkt, dass ich die beiden ja völlig legitim vergleichen könnte. Was mir auch deswegen gefiel, weil die Entscheidung zwischen den beiden von Anfang an sehr uneindeutig war, beide wirkten wie sehr gute Optionen in meiner Auswahl. Da ich von mehreren Seiten die Einschätzung hörte, dass der DT die bessere Wahl sei, wollte ich dem nun doch eine Chance im Test auf meinem Kopf geben.

Wenn das eingebaute Kabel ein nicht so wichtiger Faktor ist wie ich ursprünglich dachte, ist der Kopfhörer wirklich der bessere? Eine eindeutige Einschätzung kann ich nicht liefern, dafür sind beide zu gut. Aber ich habe jetzt ein paar mehr eigene Erfahrungen.

Aussehen und Konstruktion

Der DT 770 PRO macht einen sehr stabilen und hochklassigen Eindruck. Der Kopfbügel besteht ersichtlich aus Metall, das unten zu den Plastikohrschalen führt, und oben mit einem aufknöpfbaren Polsterband ummantelt ist. Zusammen mit dessen sichtbaren silbermetallenen Knöpfen und dem lose zu den Ohrschalen geführten Verbindungskabel schreit das Gerät "industrielles Produktdesign", was keine schlechte Sache sein muss.

Aber gerade das Metall des Rahmens mit seinen nichtmal stark abgerundeten Kanten sieht nicht gerade komfortabel aus. Zum Glück wirken da die mit grauem Velour sehr weich gepolsterten Ohrmuscheln gegen. Denn mit denen will man den DT 770 PRO doch direkt aufsetzen, und schon im ersten Moment fühlen sich die Ohrmuscheln auch so angenehm an wie sie aussehen. Auch bei etwas längerem Gebrauch wird das Material nicht unangenehm. Ich weiß nicht, wie es bei 40° im Schatten wäre – der Sommer derzeit verdient hier kaum den Namen. Aber bisher schwitzen die Ohren unter den Polstern viel weniger als man vielleicht glaubt, nämlich praktisch gar nicht.

Allerdings sind diese sehr großen Ohrenschalen auch für mich sehr ungewohnt gewesen. Und der Druck, den sie verteilen, ist nicht unbedingt gering. Es ist kein direktes festes Pressen, aber zumindest jetzt in der Anfangsphase durchaus spürbar. So sitzt der Kopfhörer zwar gut, aber ganz aus der Wahrnehmung verschwand er mir bisher nicht. Dass ich direkt am ersten Testtag fürchterliche Kopfschmerzen bekommen habe könnte damit zusammenhängen, kann aber natürlich auch Zufall gewesen sein. Immerhin wiederholte sich das nicht.

Das Kabel ist fest eingebaut. Welches Kabel es ist hängt von der Version ab. Bei der mit 250 Ohm – die mit meinem Sharkoon DAC Pro S V2 übrigens problemlos und weit ohne ans Limit zu gehen funktioniert – ist es ein Spiralkabel. Da wusste ich vom M50x, dass es für meinen Arbeitsplatz eine gute Lösung ist. Das 1,60m lange gerade Kabel der 32-Ohm-Version hätte auch funktioniert, aber das 3m-Kabel der 80-Ohm-Version wäre hier unpraktisch.

Tatsächlich gab es mit dem Kabel keine echten Probleme, wobei ich wegen des Kabelanschluss an der linken Seite langfristig den DAC auf die andere Seite das Schreibtischs kleben müsste.

Klang und Isolation

Mit seiner geschlossenen Bauform isoliert der DT 770 Pro doch einiges vom Umgebungslärm weg oder macht ihn zumindest weniger störend laut. Ohne Musik sind normale Umgebungsgeräusche immer noch gedämpft da. Sobald Musik in normaler Lautstärke läuft ist von der Umgebung wenig mitzukriegen. Klingel wie Anruf hätte ich verpasst, hätte die Büronachbarin nicht extra drauf hingewiesen, was ich auch nur gerade so mitbekam.

Den Klang empfand ich wieder als sehr gut. Was ich auch abspielte, es passte. Weder war der Bass überbetont, noch fehlten mir Höhen, noch wirkte er dumpf. Der Bass ist auch nicht schwachbrüstig – bei entsprechenden Liedern. Die kurz nach Beginn einsetzende Trommel bei Effect and Cause der White Stripes hat mich beispielsweise fast geschockt. Das abseits von Musik Sprecher in Videos problemlos zu verstehen sind ist auch klar.

Ich werde unten mehr im direkten Vergleich zum M50x sagen. Im Vergleich zum Logitech UE 6000 gilt aber, was schon beim M50x galt: Der Klang ist näher bei dessen aktiven als bei seinem dumpferen passiven Modus, aber ohne seinen überbetonten Tiefen zu reproduzieren, die mir z.B. beim Album Tempel von Colour Haze unangenehm wurden.

Was anderes als sehr guten Klang hatte ich bei all seinen positiven Kritiken aber auch nicht erwartet.

Andererseits überträgt das Kabel bei Berührung mehr Geräusche als ich erwartet hatte. Das ist nicht perfekt, kannte ich so nicht, und gerade deswegen erwähnenswert, weil das Kabel ja nicht auswechselbar ist. Der dadurch entstehende Lärm ist nicht unangenehm laut, aber wahrnehmbar. Zum Joggen wäre er ungeeignet, wenn dabei das Kabel über die Kleidung reiben würde.

Die Hauptunterschiede zum M50x

Wenn man den DT 770 PRO neben den M50x hält wirkt der letztere mehr wie ein Spielzeug. Dessen Plastikkonstruktion wirkte von Anfang an nicht sehr beeindruckend, der Klappmechanismus mehr wie eine moderne Spielerei. Und von moderner Spielerei hat der Konkurrent von beyerdynamic so gar nichts. Wie man das findet muss man selber sehen. Ich könnte verstehen, wenn das industrielle des DT 770 Pro etwas abschreckend wirkt. Andererseits wirkt es nunmal auch stabil, und wenn man dann weiß, dass Ersatzteile verfügbar sind, macht es den Kopfhörer und seine funktionale Konstruktion sehr sympathisch.

Andererseits schaut man sich dann das Kabel an, wo die Funktionalität eines wechselbaren Kabels klar dem M50x zugute kommt. Das zwar proprietär sein mag, aber dafür liegen dem Gerät gleich drei bei und damit alle Längen die man brauchen könnte, außerdem gibt es nicht zu teure Adapter. Und obwohl beide meine Vergleichskopfhörer ein Spiralkabel benutzen, ist Klangübertragung bei Reibung beim M50x kein Thema. Das muss an der Art des Kabels oder der Verbindung im Kopfhörer liegen. Und schon schaue ich etwas weniger wohlwollend auf das Gerät aus Deutschland.

Der große Unterschied sind die Ohrschalen und die Polsterung. Die vom DT 770 PRO sind sehr weich und angenehm gepolstert. Aber die Schalen sind auch sehr groß, was ungewohnt ist. Zumindest ohne ausreichend lange Gewöhnungsphase ist das zusammen mit dem höheren Druck vielleicht sogar etwas unangenehm.

Die vom M50x sind erstmal das Gegenteil: Nicht sehr weich gepolstert und eher klein. Beides zusammen macht sie im ersten Moment deutlich unbequemer. Aber an die kleinere Form bin ich eher gewohnt, dem kann ich durchaus etwas abgewinnen. Und ich hatte bei ihm – in der allerdings kurzen Zeit – weniger den Eindruck, dass beim längeren Tragen er wegen des Drucks auf den Kopf jetzt abgesetzt gehört.

Jedoch: Der DT 770 PRO gewinnt wohl den Kampf, wenn es um Komfort geht. Zumindest ist er eher den Versuch wert, ob die großen Ohrschalen als angenehm oder unangenehm empfunden werden. Insgesamt sind aber beide so gebaut, dass ich sie als unangenehmer als meinen bisherigen Logitech-Kopfhörer empfinde. Das könnte sich mit der Zeit natürlich ändern. Aber es könnte auch schlicht damit zu tun haben, dass diese beiden Kopfhörer mit Studioansprüchen da andere Prioritäten als das leichte Plastik-Consumer-Gerät mit dem Memoryschaum-Ohrpolstern haben. Egal woran es liegt, beim Komfort dürfte es stärkere Alternativen geben.

Isolieren tun beide ähnlich gut, aber der DT 770 PRO reduziert den Außenlärm etwas mehr als es der M50x schafft. Sobald Musik abgespielt wird sollten sie sich nichts nehmen, höchstens vielleicht in einem extrem lauten Großraumbüro, im Flugzeug oder im Bus. Aber in solchen Szenarien ist ein Kopfhörer mit aktiver Lärmfilterung sowieso die bessere Wahl.

Klangvergleich

Ich sollte hier noch den Klang vergleichen, finde den Vergleich aber unheimlich schwer. Es ist bei Kopfhörern sowieso schon schwierig etwas sinnvolles zu sagen, wenn nicht wie bei manchen sehr günstigen Modellen klare Macken wie ein Verzerren auftreten. Dann verhalten sich die beiden hier auch noch sehr unterschiedlich bei der Lautstärke, was sicher an der jeweiligen Nennimpedanz liegt. Mit dem Sharkoon-DAC als Treiber muss ich beim DT 770 PRO ordentlich aufdrehen, da steht der Regler schonmal bei 30% oder höher, wobei ab 20% jede Erhöhung nur noch mehr Details freizuschalten scheint anstatt simpel die Lautstärke zu erhöhen. Beim M50x stellt sich dagegen die Frage, ob 7% oder 11% die Standardlautstärke sein sollte, und die Details regelt der Softwareregler der jeweiligen Anwendung. Ein wahrscheinliches Detail des DACs: Der M50x hat mit ihm ein minimales Grundrauschen, das bei absoluter Stille wahrzunehmen ist. Der DT 770 Pro hat das nicht. Ich sehe das nicht als Faktor.

Aber das lauter besser klingt ist einer, wenn man das nicht geeicht bekommt bringt ein Hörvergleich objektiv wenig.

Nach der Vorwarnung, ich habe es trotzdem versucht. Ich hatte beim ersten Anhören beim M50x den Eindruck, dass der Klang sehr klar ist. Und das trägt sich hier weiter. Wieder ist Tempel von Colour Haze mein Vergleichspunkt, weil es das Album aller Alben ist, das ich am besten kenne. Wenn ich die beiden vergleiche meine ich auch wieder, mit dem M50x sehr viele Details wahrzunehmen. Das Album webt einen ziemlichen Klangteppich, den der M50x sehr gut rüberbringt. Es klingt immer noch so, wie ich es von meinen alten Kopfhörern gewohnt bin, nur dass ein paar Details mehr da sind, und dieses Hallen der Instrumente in seinen Extremen weniger verzerrt. Der M50x klingt hier einfach von Anfang an klasse.

Beim DT 770 PRO hatte ich da etwas mehr Mühen. Wobei der DT aber keinesfalls schlecht klingt, auch er bringt all die in diesem Album verpackten Details sehr deutlich rüber. Aber bei ihm muss ich die Lautstärke etwas mehr aufdrehen als es mir gleichwertig erscheint, bis der Klang da genauso brilliert und der Hall richtig ist, wobei der Bass dann etwas betonter ist. Als ob die großen Ohrenschalen erstmal gefüllt werden müssen. Sind sie das, dann klingt dieses großartige Album in seiner Variante sehr angenehm. Und ich meine angenehm, denn ich weiß nicht, ob es weicher wirklich trifft - zumindest ist inexakt damit nicht gemeint. Druckvoller? Egal wie man es beschreibt, subjektiv klingt auch er sehr gut.

Was passt, denn beides sollen gelungene neutral abgestimmte Kopfhörer sein. Riesenunterschiede bei Bass und Höhen wären sehr überraschend, für von mir wahrnehmbare Probleme beim Auftrennen vom Klängen sind sie zu gut, und um riesige Unterschiede bei der gehörten Größe der Bühne zu haben eignet sich die geschlossene Bauform wohl wenig. Klar, wenn man es drauf anlegt ist da schon ein deutlicher Unterschied, die Positionierung beim DT 770 PRO geht weiter vom Zentrum weg.

Doch insgesamt: Würde ich einen der beiden wegen seines Klangs klar vorziehen? Nein. Während die Zweittesterin eine klare Vorliebe für den M50x hat, schwanke ich sogar bei der Entscheidung welcher mir auch nur ein bisschen besser gefällt. Anfangs hatte ich auch eine Tendenz zum M50x, wegen seiner Klarheit. Gerade denke ich, dass der DT doch sehr angenehm ist. Hilfreich ist das nicht.

Fazit

Den DT 770 PRO doch noch anzugucken sollte mir eine klare Entscheidung verschaffen. Das Ziel erscheint mir jetzt nur noch schwerer erreichbar. Denn der Kopfhörer klingt wirklich gut, seine Konstruktion scheint mir super stabil, das Kopfpolster einfach aufknöpfbar und damit auswechselbar zu machen ist genial. Die weichen Ohrpolster verschaffen dann den nötigen Komfort. Andererseits bin ich unsicher, ob diese weichen Ohrpolster nicht mit etwas zu viel Druck auf meinen Kopf gepresst werden. Davon merkt man anfänglich nichts, aber in den ersten Tagen wurde ihn zu tragen mir schnell plötzlich unangenehm. Es brauchte zumindest etwas Gewöhnung. Diesen Effekt hatte der M50x auch anfangs nicht, dafür sind seine Polster generell unbequemer und er bleibt daher auf dem Kopf präsenter, was ein Nachteil ist.

Das nicht wechselbare Kabel des DT 770 PRO stört mich schon, dass es Berührungen mehr transportiert als der M50x hilft da nicht. Andererseits ist letzteres in der Praxis nicht störend gewesen, selbst beim Tippen dieses Artikels (wobei die Hand manchmal das Kabel streift) mit Musik im Hintergrund.

Wenn auch keine einfache Entscheidung, so brachte der Test doch eine Erkenntnis: Der Vergleich macht deutlich, dass ich mit den begrenzten Komfort der Ohrpolster des M50x nicht eingebildet habe. Wenn ich den behalte würde ich die wohl tatsächlich auswechseln. Vielleicht wäre das eine gute Route vorwärts. Und wenn der M50x mir dann irgendwann kaputtginge, dann könnte ich den DT 770 PRO nochmal kaufen. Selbst wenn ich ihn am liebsten direkt hierbehalten würde. Das ist völlig unvernünftig, aber ja: So gut finde ich ihn.

Vom Preis nehmen die beiden sich nicht viel. Direkt vom Hersteller kostet auch dieser Kopfhörer 129€, wobei die Webseite direkt einen 10%-Begrüßungscoupon anbietet, das reduziert ihn auf 116€. Garantiezeit ist dann nur zwei statt wie bei Thomann drei Jahre, dafür ist der Rückgabezeitraum mit 60 Tagen doppelt so lang.

Linkdump 31/2021

Friday, 6. August 2021

Collections: The Queen’s Latin or Who Were the Romans, Part V: Saving And Losing an Empire ist ein sehr langer Artikel und doch nur ein fünfter Teil einer Serie. Trotzdem gut investierte Zeit. Selbst alleine ist er eine sehr interessante Erklärung der Diversität des Römischen Reichs und wie sie als Stabilitätsfaktor wirkte. Er überzeugt auch darin, dass die Römer nicht so aussahen wie wir uns das oft vorstellen, was die vorherigen Artikel noch ausbauten.

Das Framework-Laptop ist nicht nur ein interessantes Konzept (wie gezeigt im Blog), sondern scheint auch insgesamt ein richtig gutes Laptop geworden zu sein. Linus (von LTT) sah man selten so ehrlich begeistert wie in A Completely Upgradeable Laptop?.

So ein DIY Headtracker for gaming (on Linux PC) ist toll und es ist immer wieder beeindruckend, was Leute bauen können. Ich wusste nichtmal, dass die Hard- und Software das zulässt – und dabei lebt hier im Haus eine Physikerin, die grob in dem Bereich arbeitet.

Bei AMD Ryzen 5000G: iGPU im Test: Zen 3 beschleunigt die APU im Spiele-Einsatz zeigt sich zwar genau, was der (vermurkste) Titel besagt. Daher werden mit dem neuen Release solche integrierte Grafiklösungen für bescheidene Spieler noch mehr spieletauglich als sie bisher schon waren. Trotzdem finde ich es enttäuschend, dass AMD in diesen APUs für die Grafikeinheit immer noch die alte Vegatechnik verbaut. Die APU im Steam Deck dagegen soll die neue RDNA2-Architektur bekommen, was einen Riesensprung bringen müsste. Aber das wäre gerade jetzt auch für normale PCs richtig sinnvoll, weniger wenn es in Zukunft wieder reguläre Grafikkarten zu kaufen gibt. AMD verpasst hier eine Chance.

Die alternative fiktive Geschichtsschreibung mit Hearts of Iron IV

Wednesday, 4. August 2021

Hearts of Iron IV hat mich in meinem momentanen Durchlauf sehr damit überrascht, wieviele Möglichkeiten es dem Spieler gibt und wie gut es Spielerentscheidungen aufgreift.

Vorab: Es ist ein Spiel über den zweiten Weltkrieg. An sich ist es ein unappetitliches Thema und es klingt nicht toll, darüber zu schreiben. Ich will mich durch diese Erkenntnis aber nicht selbst zensieren – es ist ein Spiel und mit diesen extremen Situationen zu spielen macht Spaß, was da historisch hinter steckt ist dafür egal. Les diesen Artikel bitte entsprechend.

Polens Verteidigung als Knobelaufgabe

Im letzten Artikel zum Spiel beschrieb ich schon, dass ich mit Polen am Knobeln war. Dabei ist die KI auf historisch gestellt, spielt also Ereignisse von damals nach, was für Polen gar nicht gut ist. Aber das macht es zur interessanten Herausforderung: Mit welcher Entscheidung kann es die historische denkbar ungünstige Lage überstehen? Geht das überhaupt? Ich versuchte es erst mit stumpfer Verteidigung, und (als Anfänger) scheiterte ich gegen die Naziarmeen. Die Fraktion mit den baltischen Staaten half auch nicht, die Staaten haben einfach kaum Armeen. Litauen vor dem Krieg einzunehmen half deutlich mehr, aber es war nicht genug.

Daher warf ich diesmal einen Blick auf die Tschechoslowakei. In meinen Durchgängen davor war die immer vor Kriegsbeginn von Nazideutschland annektiert worden. Die Grenze zu verteidigen band eine der polnischen Armeen, die aber an der Westfront gebraucht würde. Die Armee im Süden kann gewinnen, aber nicht ausreichend schnell, bis dahin ist Warschau gefallen. Also: Der Plan diesmal war, vor dem Überfall auf Polen statt dem neutral bleibenden Litauen dieses ansonsten später feindliche Land einzunehmen. Es würde die Westfront verkürzen und die dritte Armee freischaufeln, so rechnete ich mir eine echte Chance aus.

Plötzlich Krieg

Was ich nicht beachtet hatte: Die Unabhängigkeit der Tschechoslowakei wurde erst von Frankreich, dann von den Briten garantiert. Zwischendurch mal von keinem der Alliierten, aber den Moment verpasste ich. Als der Kriegsgrund vorbereitet war hatte ich keine Wahl mehr: Ich musste trotzdem angreifen, sonst wäre die Verteidigung chancenlos. Die Hoffnung: Die Briten werden das ignorieren. Sie taten es nicht. Gegen die Alliierten alleine war Polen aber auch wieder chancenlos, der Durchgang war gelaufen, dachte ich.

Stattdessen griff auf einmal Nazideutschland auf Polens Seite in den Krieg ein! Und bot dem Land den Eintritt in die Achsenfraktion ein, als nicht-faschistisches Land eine echte Überraschung. Historischer Irrsinn, aber da die Alliierten sonst zu 100% Polen vernichtet hätten blieb wieder wenig Wahl. Und so startete in dieser Variante der Geschichte Polen 1938 den zweiten Weltkrieg.

Ergebnis: Eingebautes Doomsday-Szenario

Gegen Frankreich und Großbritannien wäre er gewinnbar gewesen, vor allem mit Italien als bald dazukommenden Verbündeten. Aber dann erklärte die UdSSR von sich aus Nazideutschland den Krieg. Das Diplomatiesystem hätte es durch den freiwilligen Eintritt in die Fraktion noch gestattet, Polen da herauszuhalten, aber dann hätten die Alliierten ohne den Nachbarstaat bald freie Hand gegen Polen gehabt. Die Ostfront war eine ganze Weile zu halten, aber nicht gewinnbar (Moskau fiel nie), dann kam die USA bei den Alliierten dazu und es war vorbei.

Naja, vorbei trifft es nur so halb. Es war dann ungefähr die echte Ausgangslage von 1945, ich durfte Polen mit veränderten Grenzen, als Vasallenstaat der Sovjetunion und anfänglich ohne Armee weiterspielen; aber neue Einheiten produzieren. Weniger historisch dann der weitere Verlauf: Die UdSSR eroberte erst die baltischen Staaten, dann Finnland, und plötzlich waren die Alliierten wieder als Feinde markiert. Dritter Weltkrieg! HoI4 hat das Doomsday-Szenario des zweiten Teils scheinbar direkt mit integriert.

Mittlerweile flogen die ersten Atombomben (das Kräfteverhältnis ist ziemlich ausgewogen), aber nicht auf Japan, sondern auf London und Warschau… Und ich frage mich, ob sich dieser Krieg entscheiden wird bevor ich das Interesse verliere oder ob das Spiel einen eingebauten Endpunkt hat.

Doch egal wie das jetzt endet, diese erste Geschichtsumschreibung war toll. Das ganze Spiel folgte aus der Entscheidung die Ausgangslage anders zu lösen, die KI (oder das eingebauten Regelsystem) griff das auf und plötzlich war der ganze Verlauf der Geschichte umgeschrieben, trotz einer sich ansonsten relativ historisch korrekt verhaltenden KI, ohne dass das Spiel kaputtging. Nach all der relativen Chancenlosigkeit zuvor war das eine angenehme Überraschung. Vorher war es ein Anrennen gegen unbewegliche Mauern, auf einmal war alles im Fluss.

Und ich finde, dieser Effekt und der hier beschriebene Spielverlauf zeigt den Reiz dieser Art von Globalstrategie ganz gut.